Dieser Beitrag ist in zwei Sprachen verfasst. Click here for the English version.

KI — Was, Warum, Wie

Hallo und willkommen zu meinem kleinen Podcast‑Begleittext über Künstliche Intelligenz.

Was ist das? Warum benutzt man sie? Und wie funktioniert das eigentlich in der Praxis?

Die folgenden Gedanken basieren auf einem Vortrag bzw. einer Workshop‑Reihe, die ich in den letzten Jahren öfter gegeben habe. Ich habe das Ganze vertont – und hier bekommst du die textliche Fassung dazu, damit du dir in Ruhe einen Überblick verschaffen kannst.

Vorweg: KI bewegt sich schnell. Darum konzentriere ich mich auf Punkte, die grundsätzlich und dauerhaft hilfreich sind. Dann legen wir los.

Was ist künstliche Intelligenz – wirklich?

Eine Definitionsmöglichkeit hat der englische Ethiker Mark Coeckelbergh in seinem Buch AI Ethics formuliert:

Künstliche Intelligenz ist eine Intelligenz, die mit technologischen Mitteln angezeigt oder simuliert wird. Am Maßstab menschlicher Intelligenz gilt sie als „intelligent“, wenn sie die Arten von Fähigkeiten und Verhaltensweisen reproduziert, die Menschen zeigen.

Es gibt natürlich auch andere Definitionen – je nach Fachgebiet und Perspektive. Spannend finde ich hier die enge Kopplung: Menschliche und künstliche Intelligenz werden wechselseitig aufeinander bezogen. Erst musst du klären, was „künstlich“ im Unterschied zu „menschlich“ bedeutet – und was wir überhaupt unter „Intelligenz“ verstehen. Eine einheitliche Antwort gibt es über die Disziplinen hinweg nicht.

Für den praktischen Technik‑Alltag hilft mir ein anderer Startpunkt: Was ist KI – und was nicht? Heute bekommt vieles das Label „KI“, obwohl es in Wahrheit gut gemachte, klar definierte Algorithmen sind.

Ein Algorithmus folgt einer festen, vorgegebenen Abfolge von Schritten, um auf Eingaben zu reagieren. Von KI sprechen wir eher, wenn etwas Neues generiert wird, wenn Zufall eine Rolle spielt oder sehr große Datensätze im Spiel sind.

Generative KI – etwa ChatGPT für Text oder Midjourney und Stable Diffusion für Bilder – sind dafür gute Beispiele. In die Verarbeitung deiner Anweisung (deines Prompts) fließt viel Rechenleistung. Solche Systeme kommen auch mit ungewohnten Nutzungsmustern zurecht. Klassische Formeln in einer Tabellenkalkulation hingegen brechen leicht, wenn du völlig andere Daten hineinkippst. Aus dieser Perspektive lässt sich zwischen klassischen Algorithmen und KI unterscheiden – auch wenn selbst diese Grenze nicht endgültig ist.

Technische Grundlagen – der „stochastische Papagei“

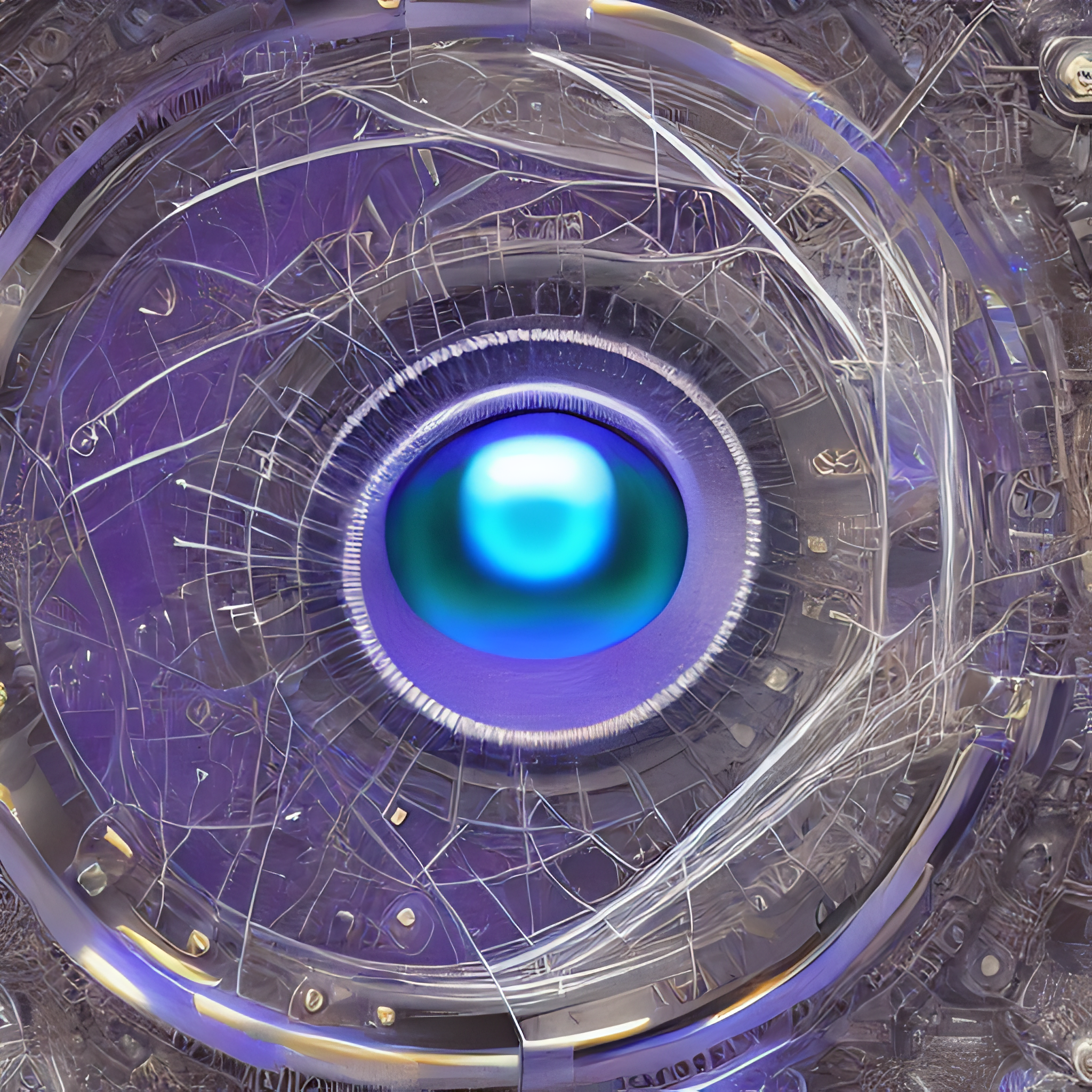

Ich bin kein Informatiker; es geht hier nicht um Mathe‑Tiefflug. Um die Wirkung von KI im Alltag zu verstehen, reicht ein Bild, das in der Informatik geprägt wurde: die KI als stochastischer Papagei. „Stochastisch“ heißt: Wahrscheinlichkeiten, Würfeln, Muster. „Papagei“ heißt: nachplappern.

Ein trainiertes KI‑Modell – für Text, Bilder, Audio oder Video – erzeugt Ausgaben ohne menschliches Verständnis. Da ist nichts, das „versteht“, „erkennt“ oder „fühlt“, was produziert wird. Stattdessen werden im Vorfeld große Mengen an Texten, Bildern und anderen Daten analysiert. Das System findet Muster und bildet sie statistisch ab. Deine Eingabe wird mit diesem gelernten Musterbestand abgeglichen – und darauf reagiert das System. Man kann es sich wie ein Gespräch zwischen Datenbestand und deinem Anliegen vorstellen. Hinter den Kulissen wirken weitere Parameter und Verfahren – oft das „Geheimrezept“ der Firmen. Entscheidend ist: Es wird berechnet, welche Wörter wahrscheinlich folgen oder welche Pixel gesetzt werden.

Das Mini‑Beispiel kennst du vom Smartphone: Du tippst „Sehr geehrte Damen und Herren“ und die nächsten Wörter werden dir vorgeschlagen. Große Sprachmodelle tun Ähnliches – nur auf viel größerer Datenbasis und mit Nachbearbeitung. Im Kern kann eine Maschine aber nur „sagen“, was sie gelernt hat – kombiniert, neu zusammengesteckt, manchmal überraschend kreativ. In diesem Sinn plappert die KI Muster zurück.

Faktentreue und Fehler

Die naheliegende Frage: Kann KI sachlich korrekt antworten? Wenn Ausgaben das Ergebnis von Wahrscheinlichkeiten sind, ist „am wahrscheinlichsten“ nicht automatisch „wahr“. Details können falsch sein. Bildmodelle zeigen Artefakte (erinnere dich an extra Finger oder verschmierte Schrift in den ersten KI-Bildern). Bei Texten ist es tückischer: Falsches kann plausibel klingen. Frühere Modelle konnten ausführlich erklären, warum der Himmel grün ist – sehr überzeugend – und doch falsch liegen.

Die Unternehmen haben Korrekturschichten eingebaut, ohne alles offenzulegen. Trotzdem zeigen neuere Untersuchungen: Auch aktuelle Modelle machen Fehler, oft weil sie lieber irgendeine Antwort geben, statt „ich weiß es nicht“. Wüsste ein System wirklich, dass es etwas nicht weiß, würde es den Fehler nicht produzieren. Bei Bildern erkennst du Unstimmigkeiten schneller, bei Texten eher später.

Hinzu kommt: Viele Tools durchsuchen inzwischen das Netz und zeigen Quellen an. Das wirkt gut – es gibt kleine Zitat‑Blasen zum Anklicken. Aber auch das hat eine Voreingenommenheit. Du siehst nicht, welche Quellen nicht ausgewählt wurden. Wer schon mal auf Seite 3, 4 oder 5 der Suchergebnisse gelandet ist, weiß: Da liegt oft Nützliches. Wenn die KI für dich auswählt, entgeht dir der Rest. Nutze Quellenangaben als Hilfe, nicht als endgültigen Beweis.

Warum KI einsetzen – oder auch nicht?

Starte mit deinem Warum. Wer weiß, warum er etwas tut, findet leichter Wege, wie und was zu tun ist. Das gilt bei KI besonders, weil sie theoretisch überall ansetzen kann. Frag dich: Warum setze ich das ein? Welche Rolle spiele ich im Prozess?

Ein einfacher Einstieg: Kläre deine Erwartung. Möchtest du Zeit sparen? Etwas Neues ausprobieren? Ein konkretes Problem lösen? Das hilft beim Formulieren von Prompts – und manchmal merkst du: „Das kann ich auch selbst.“ Menschen können zuhören, verstehen, Vertrauen aufbauen. Gerade in kirchlichen Kontexten zählt das viel.

Denk auch über deine Zeit nach. Wenn Leute fragen: „Was kann man mit KI alles machen?“, empfehle ich einen Blick auf die ganze Woche. Wenn das, was du gerne machst – z.B. eine Predigt schreiben, eine Andacht, einen Vortrag – etwas ist, das du selbst am besten tust, dann schau auf die anderen Stellen, an denen KI Zeit sparen kann, damit du Zeit für das Wichtige hast. Beispiel: Eine heikle E‑Mail. Lass dir von KI Entwürfe geben, um in Gang zu kommen.

Aber: Du musst KI nicht überall nutzen. Wenn du eine Aufgabe nur machen willst, „weil KI das kann“, frag dich ehrlich, ob die Aufgabe überhaupt nötig ist. Wenn im Gremium niemand deiner regelmäßigen Andacht zuhört, rede vielleicht mit der Runde darüber, warum ihr die Andacht haltet – statt reflexhaft KI einzusetzen.

Am Ende bleibst du verantwortlich für das, was du veröffentlichst. Wenn du zu viel auslagerst, verlierst du Nähe zur Sache. Das Ringen um Worte – zum Beispiel bei einer Predigt – ist Teil des Ergebnisses.

Um Verantwortung zu tragen, brauchst du ein Grundverständnis davon, was KI tut. Kein Vollstudium, aber genug, um prüfen zu können. Und noch eine Frage: Fühlt sich der Einsatz von KI für dich stimmig an – mit Werten und Berufung? In einem Seminar fragte jemand: Kann eine KI‑Predigt vom Heiligen Geist inspiriert sein? Tiefe theologische Fragen. Praktisch bleibt: Ist es noch deine Arbeit?

Ich bin hier bewusst vorsichtig. Wenn wir KI überhöhen, messen wir unser Tun ständig an der Maschine. Wenn wir KI als Werkzeug sehen – wie Stift, Papier, Schreibmaschine –, kann sie helfen. Frag dich: Welcher Anteil bist du? Welcher Anteil ist die KI? Mit einer nüchternen Haltung im Alltag fügt es sich stimmiger.

Wie KI nutzen: Haltung zuerst

Bevor du Tools auswählst, geht es um Haltung. Du kannst KI als Werkzeug in deinen Ablauf stellen: Du stehst vor der KI, weißt, was du willst, gibst einen Auftrag, prüfst das Ergebnis, iterierst, behältst Richtung und Tempo.

Mein Lieblingsbild ist das E‑Bike. Ein E‑Bike ist kein Moped. Du trittst selbst. Ab einer Geschwindigkeit hilft der Motor nicht mehr. Du lenkst. So auch mit KI: „KI, mach meinen Job“ funktioniert nicht. Du bringst eigene Leistung ein und lässt dir dort helfen, wo es hakt. Vielleicht schaust du nicht mehr auf ein leeres Blatt, sondern auf einen Rohtext – das Finale machst du.

Das Gegenbild ist das Fließband. Du stehst hinter der KI. Du feilst am Prompt und nimmst das erste Ergebnis. Die KI legt Struktur, Stil und Inhalt deines Textes fest – oder die Bildsprache und Farben deines Bildes. Das ist bequem und schnell, aber dein Werk verliert Tiefe. Und du kannst es nicht wirklich vertreten. Es wäre, als würdest du ein Stichwort tippen, am Sonntag eine KI‑Predigt vorlesen und hinterher nicht sagen können, warum du das so gepredigt hast. Menschen gehen davon aus, dass du es geschrieben hast. Darum: reflektierter Einsatz, Kontrolle behalten, Ergebnis verantworten.

Das Krüger‑Axiom

Marcel Krüger, ein Freund von mir, hat es so auf den Punkt gebracht:

Um KI als Werkzeug zu benutzen, musst du zuerst das Handwerk verstehen.

Was heißt das? Starte mit Aufgaben, die du auch ohne KI gut könntest. Wenn ich eine KI Teile einer Predigt entwerfen lasse, muss ich beurteilen können, ob das trägt. Als ausgebildeter Theologe merke ich, wenn der Ton nicht passt, theologische Nuancen schief sind oder der Text schlicht langweilt. Um zu verbessern – durch neues Prompting oder durch Bearbeitung in Word – brauche ich Fachwissen. Das gilt in deinem Feld genauso. Im Konfi‑Kurs musst du deine Jugendlichen kennen. In der Bildarbeit brauchst du ein Gefühl für Motive und Wirkung.

Wenn du dein Handwerk kennst und die Stärken und Grenzen der KI einschätzen kannst – wo du ihr trauen kannst und wo sie abdriftet –, kannst du sie in unbekannten Bereichen einsetzen, etwa bei einem Hobby. Dort prüfst du mit anderen Quellen gegen, und das Risiko ist klein. Da kann KI Sparringspartner sein. Wovon ich abrate: KI blind zu nutzen, wo du die Ergebnisse nicht verifizieren kannst. Bei mir ist das Finanzen. Ohne Expertise würde ich keine Aktienberatung von KI übernehmen – ich könnte nicht beurteilen, ob ich Geld verbrenne. Wenn du dich auskennst oder etwas lernst und es nicht kritisch ist, kann KI helfen.

Gesellschaftliche und ökologische Herausforderungen

Bias/Verzerrung. KI kann nur aus dem lernen, was sie gesehen hat – und Datensätze sind nicht perfekt. Online steht viel Falsches; Bilder können irreführen. Modelle reproduzieren das. Das führt zu Diskriminierung. Eine Zeit lang zeigten Bildmodelle bei „Krankenhauspersonal“ häufig männliche Ärzte und weibliche Pflegekräfte. Natürlich gibt es Chefärztinnen und männliche Pfleger, diese wurden aber selten generiert. Genau hier bist du gefragt: Wenn du den Bias gar nicht bemerkst, veröffentlichst du ihn und verstärkst ihn. Dem kannst du entgegnen, wenn du dein Bewusstsein schulst. Das nimmt dir KI nicht ab.

Datenschutz und Privatsphäre. Ein großes Thema ist die Herkunft der Trainingsdaten. Vieles wurde aus dem Netz kopiert – ohne Zustimmung. Deswegen laufen sogar Rechtsstreitigkeiten. Beispiel: Stand September/Oktober 2025 sind die New York Times und OpenAI in laufender Auseinandersetzung. Das hat Folgen dafür, was gespeichert und was gelöscht wird. Firmen werben mit Sicherheit. Aber kannst du sicher sein, dass deine Prompts, Texte und Bilder nicht in der nächsten Modellversion landen? Meine Faustregel: Tippe nur das in eine KI, was du auch mit Kreide auf einen Marktplatz schreiben würdest. Keine persönlichen Daten, keine Telefonnummern, keine Orte, keine seelsorgerlichen Inhalte. Du hast keine Kontrolle, was danach passiert.

Arbeit und Berufe. Der Druck ist spürbar. Illustrator:innen, Texter:innen, Autor:innen – sogar Seelsorge und Psychotherapie – bekommen Konkurrenz durch KI‑Angebote. KI kündigt niemandem. Aber Organisationen streichen Einstiegsrollen: „Das macht jetzt die KI.“ Bitter, wenn Modelle zuvor an Werken genau dieser Leute trainiert wurden. Wir als Kund:innen entscheiden mit. Ja, KI spuckt schicke, fotorealistische Bilder aus. Aber vielleicht gibt es bei dir vor Ort jemanden, der das beruflich macht und einen Auftrag brauchen kann. Oder du machst es selbst.

Automation Bias. Ein Thema, das mir sehr wichtig ist. Wir neigen dazu, den Ergebnissen von Maschinen mehr zu glauben als wenn sie von Menschen kommen. Beim Taschenrechner ist das sinnvoll: 2 + 2 = 4, immer. KI ist nicht deterministisch und macht Fehler. Wenn KI dir Zeit spart, sinkt leichter die Sorgfalt beim Prüfen. Dann fällst du auf die Nase – vielleicht sogar auf der Kanzel, wenn du mitten in der Predigt merkst, dass etwas nicht stimmt, oder später an der Tür. Am Ende trägst du Verantwortung. Darum: Bleib wach. Frag beim Einsatz von KI: was, warum und wie – damit du dir und anderen Auskunft geben kannst.

Ein schneller Produktüberblick

Bis dieser Text erscheint, hat sich der App‑Markt wahrscheinlich schon gedreht. Darum hier Kategorien und mögliche Einsätze in Gemeinde‑Nähe:

Text‑KIs: Für Predigten, Gemeindebriefe, Unterrichtsmaterial, Gebetsimpulse, E‑Mails, Website‑Texte. Auch für Übersetzungen.

Bild‑KIs: Eher für Plakate und Social Media, vielleicht für ein Podcast‑Logo oder eine Grafik für den Schneideplotter. Viele KI‑Bilder wirken „geleckt“ – das erkennen Leute inzwischen. Mancher reagiert ablehnend. Hilfreich sind sie bei einfachen Symbolen oder Illustrationen, vor allem wenn du nachbearbeitest. Oder zur Ideenfindung in der Fotografie. Bedenke: Ein schlechtes KI‑Bild kann Leser:innen abschrecken – selbst wenn der Artikel gut ist, der dann nicht mehr gelesen wird.

Sprach‑KIs: Wandeln Sprache in Text und Text in Sprache. Gut für Barrierefreiheit oder fürs Vorlesen längerer Texte. Man kann Schnipsel in Podcasts einbauen – sparsam. Wenn klar ist: „Das ist die Hörversion eines Artikels“, passt es. Wenn die halbe Folge aus KI‑Stimme besteht, bleibt ein schaler Eindruck. Ich würde es lassen.

Video‑KIs: Man kann kurze Füllclips erzeugen. Ich bin aber skeptisch, vor allem wegen des Energieverbrauchs. Je komplexer die Aufgabe, desto mehr Ressourcen werden gebraucht: Wasser zum Kühlen der Rechenzentren, sehr viel Strom. Bei Video‑Modellen ist das enorm. Ein viersekündiger Clip mit Google Veo verbraucht Strom, mit dem du etwa 60 Kilometer E‑Bike fahren könntest. Zwei Miniclips – und ein E‑Bike‑Akku ist sinngemäß verbraucht. Die MIT Technology Review hat solche Größenordnungen neulich hervorgehoben. Text‑ und Bild‑Modelle liegen deutlich darunter. Nutze also lieber eine Text‑KI, um den Schnitt zu planen, und dreh das Video selbst – das ist oft grüner und kreativer.

Musik‑KIs: sind sehr umstritten. Plattformen wie Spotify oder Apple Music werden mit KI‑Tracks geflutet. Für ein Experiment im Konfi‑Unterricht ist der Einsatz okay. Aber das ersetzt nicht echtes Spielen und Singen.

Ausblick und Schluss

Das war der Überblick: Was KI ist, warum du sie nutzen könntest – oder eben nicht – und wie du dich ihr gegenüber aufstellen kannst. In weiteren Teilen spreche ich über Haltung und Verantwortung, darüber, wie man KI und Schneideplotter zusammenbringt (ich habe dazu einen Workshop gegeben, bei dem wir Grafiken generiert und danach geschnitten haben), und gebe einen kurzen Einstieg, wie Schneideplotter grundsätzlich funktionieren.

Wenn dich das interessiert, hör gern wieder rein. Danke fürs Lesen und Zuhören. Bei Fragen melde dich über elektropastor.de. Ich bin gespannt, was du zum Thema KI zu sagen hast. Mach’s gut!

English version: AI — Why, How and What?

Hello and welcome to my little podcast on artificial intelligence.

What is it? Why do people use it? And how does it actually work?

This is based on a talk—a series of workshops—I’ve given repeatedly over the past few years. I decided to record it so you can listen and get a quick overview.

Up front: AI is moving fast. So I’ll focus on things that are broadly and consistently important. Let’s dive in.

What is artificial intelligence, really?

Here is one definition, given by the English ethicist Mark Coeckelbergh, in his book AI Ethics:

Artificial intelligence is an intelligence that is displayed or simulated by technological means. Judged by the standard of human intelligence, it is considered “intelligent” when it reproduces the kinds of intelligent abilities and behaviors humans display.

That’s an interesting definition. There are others, of course, depending on the field and perspective you come from. What I find striking here is how tightly linked human intelligence and artificial intelligence are—each is defined in relation to the other. First you’d have to say what makes something “artificial” as opposed to “human,” and what we mean by “intelligence” in the first place. Across disciplines there isn’t a single settled answer.

For my purposes—technology and practical use—it helps to start from what AI is and what it isn’t. Lots of computer processes get labeled “AI” today when, in reality, they’re just well‑designed algorithms.

An algorithm means a program follows a fixed, predefined sequence of steps to respond to an input. By contrast, we usually talk about AI when something new is generated, when randomness plays a role, or when very large datasets are used.

Generative AI—like ChatGPT for text or Midjourney and Stable Diffusion for images—are solid examples of what we typically call “AI.” A lot of compute goes into processing the user’s instruction (the “prompt”). These systems can also handle unexpected usage patterns fairly well. If you apply standard formulas in a spreadsheet and then feed totally different kinds of data, those formulas tend to fall apart. Seen from that angle, you can draw a line between classic algorithms and AI—though even this distinction isn’t final.

Technical foundations, briefly

I’m not a computer scientist, so I won’t go deep into the math. You don’t need that to grasp how AI affects our lives. A picture from computer science that I find helpful—though debated—is AI as a “stochastic parrot.” Two words matter here: “stochastic” (think probability, dice, randomness) and “parrot.” The AI echoes back what we ask for, guided by patterns in the data we give it.

A trained AI model—whether for text, images, audio, or video—doesn’t generate output with human‑like understanding. There’s nothing in there that “understands,” “recognizes,” or “feels” what it produces. Instead, huge amounts of text, images, or other data are analyzed in advance. The system finds patterns and represents them statistically. Your prompt is compared to that learned statistical representation, and the system responds accordingly. You can think of it as a conversation between the dataset and your request. There are more parameters and algorithms behind the scenes—often the “secret sauce” of big companies—but the key point is: the system computes which words are likely to follow, or which pixels should be generated, based on probabilities.

You already know a tiny version of this from text suggestions on your phone. Type “Dear Sir or Madam,” and your keyboard predicts the next likely words. Large text models do this on a far larger scale and with post‑processing. At heart, though, a machine can only “say” what it has learned—combined, remixed, sometimes in creative ways. In that sense, it’s still parroting patterns back to us.

Truthfulness and errors

A common question is whether an AI can answer factually. If the output is the result of probabilistic choices—what is most likely given the data—then “most likely” isn’t always “true.” Details can be wrong. Image models may show visual artifacts (think the early days of extra fingers or smeared text). With text, the risk is that wrong statements can sound plausible. Early text models could explain at length why the sky is green—very convincingly—and still be wrong.

Companies have added various correction layers they don’t fully disclose. Still, recent studies show that even newer models produce more errors than you’d expect, partly because they “prefer” to give an answer rather than say “I don’t know.” And if a system truly “knew” it didn’t know, it wouldn’t make that mistake in the first place. So we’re in a bit of a bind when it comes to truthfulness, especially with text (errors in pictures are easier to spot).

Another point: more and more tools now search the web and cite sources. That looks great—you get little citation bubbles you can click. But there’s bias there, too. You don’t see which sources were ignored. Anyone who has dug into page 3, 4, or 5 of search results knows there’s often useful material beyond page 1. If the AI picks the sources for you, you don’t know what you’re missing. Treat citations as helpful, not definitive.

Why use AI—or not?

It’s good to start with your “why.” If you know why you’re doing something, you’ll get better ideas about how to do it and what to do. That’s especially true with AI because it could, in theory, touch almost every part of life. So ask: why am I using this, and what role do I play in the process?

A simple entry point: clarify your expectations. Do you want to save time? Try something new? Solve a specific problem? That helps you later when crafting prompts—and sometimes you’ll realize, “I could just do this myself.” Humans are still better at listening, understanding, and, in church settings, building trust through the words we write or speak. Often it’s more natural to act as a human.

Also consider how you want to spend your time. When people ask what to do with AI, I suggest taking a weekly overview. If your favorite work—say, writing a sermon, a devotional, or a talk—is something you do best yourself, then look for the other moments in the week where AI could save time so you can protect the work you value. For example, if a difficult email tone is tripping you up, you can ask AI for drafts to get unstuck.

That said, you don’t have to use AI everywhere. If you notice you hate a task and only want to do it “because AI can,” it might be more honest to ask whether the task should exist at all. If no one listens to your regular devotion in a committee meeting, perhaps talk with the group about why you gather for devotion—rather than defaulting to AI.

Remember, you remain responsible for what you publish. You also risk losing some closeness to the work if you outsource too much. Wrestling with wording—like when writing a sermon—is part of the final result.

To carry responsibility, you need a working grasp of what the AI is doing. You don’t need to know everything, but you should be able to check the output. More on that in a moment. One last question here: does using AI still feel coherent with your values and vocation? In a seminar on AI and preaching, someone asked whether an AI‑written sermon could be “inspired by the Holy Spirit.” Those are deep theological questions. But practically: is it still your work?

I’m cautious here. If we inflate AI into a cure‑all, your work will constantly be measured against the machine. If, instead, you treat AI as a tool—like a pen, paper, or typewriter—it can help. Ask: what percentage is you, and what percentage is the AI? Used with nuance in everyday work, things knit together more cleanly.

How to use AI: stance first

Before tools, think attitude. You can use AI as a tool in your workflow: you stand “in front of” the AI, know what you want, give an instruction, evaluate the result, iterate, and keep control of direction and pace. My favorite image here is an e‑bike. An e‑bike isn’t a moped. You still have to pedal. There’s a top speed where the motor stops helping. You have to steer. Same with AI: you can’t say “AI, do my job.” You put in your own effort and let AI help where it’s hard. Maybe you don’t face a blank page anymore—you have a draft—but you finish the work.

The opposite image is a conveyor belt. You stand “behind” the AI. You craft a prompt, then accept the first result. The AI has effectively chosen structure, style, and content for your text—or the visual language and colors for your image. That’s comfortable and fast, but your work may lose depth, and you can’t really stand behind it. It’s like typing a keyword, reading an AI sermon from the pulpit on Sunday, and then being unable to explain why you preached what you did. People encountering the result assume you made it. That’s why reflection matters. I strongly recommend keeping control of the process and owning the outcome.

The Krüger Axiom

Marcel Krüger, a good friend of mine, once put it like this:

To use AI as a tool, you must first understand the craft.

What does that mean? When you start using AI, begin with tasks you could also do well without AI. If I have an AI draft a sermon—or chunks of one—I need to judge whether it works. As a trained theologian I can notice when the tone is off, when theological nuances are wrong, or when it’s just boring. To improve it—either by prompting again or by editing in Word—I need domain knowledge. The same is true in your field. If you run confirmation classes, you need to know your teens. If you’re doing creative visual work, you need at least a feel for how images work.

Once you know your craft and the AI’s strengths and limits—what you can trust it with and where it veers off—you can start using it in unfamiliar areas, like a hobby, where you have other sources to cross‑check and the stakes are low. There, AI can be a handy sidekick and brainstorming partner. What I’d caution against: using AI blindly where you can’t verify the output. For me, that’s finance. Without expertise, I wouldn’t take stock market advice from an AI because I couldn’t tell if I’m wasting money. If you know your stuff or you’re learning something new and it’s not critical, AI can be a helpful partner.

Societal and environmental challenges

Biases. AI can only produce from the data it was trained on—and datasets aren’t perfect. Some information online is simply wrong; some images are misleading. The model will reproduce that unless steps are taken. This can lead to discrimination. For a while, image models prompted for “hospital staff” tended to produce male doctors and female nurses. Of course there are also female chief physicians and male nurses, but early outputs didn’t reflect that. That’s where you come in: if you don’t notice a bias, you might publish and amplify it. To avoid that, users need awareness and training. AI can’t take that responsibility off your shoulders.

Privacy and data protection. Another big issue is data sourcing. A lot was scraped from the internet without permission, and lawsuits are ongoing. For example, as of September/October 2025, The New York Times and OpenAI are in active litigation. This has implications for what is stored and deleted. Companies promise safety, but can you be sure your prompts, texts, and images won’t be used to train the next model? My rule of thumb: only type into an AI what you’d be willing to chalk onto a public square for everyone to read. Don’t put in personal data, phone numbers, locations, or pastoral care matters—you don’t control what happens afterward.

Jobs and work. We’re already seeing pressure on certain professions: illustrators, copywriters, authors, even pastoral care and psychotherapy face competition from AI offerings. AI doesn’t directly “fire” anyone, but organizations may cut entry‑level roles: “The AI can do that now.” That’s rough—especially if the models were trained on those creators’ work without consent. As customers, our choices matter. Yes, AI can spit out slick, photorealistic images. But maybe someone in your community does this professionally and could use the work. Or maybe you can make it yourself.

Automation bias. This one is dear to me. You know the sentence, “We’ve always done it this way.” With machines we often assume, “If the computer says so, it must be right.” That trust makes sense with calculators—2 + 2 = 4 every time. But AI is non‑deterministic and makes mistakes. As AI saves you time, your diligence in checking results can slip. Then you get burned—maybe even in the pulpit, discovering mid‑sermon that something isn’t right, or hearing it at the door afterward. In the end, you are responsible for what you publish with AI. So keep reflecting on what you’re doing, why, and how—so you can give an account to yourself and to others.

A quick product landscape (without name‑dropping)

By the time this episode is out, half the apps will have changed, so I’ll stick to categories and church‑adjacent uses.

Text AIs: good for sermons, newsletters, teaching materials, prayer prompts, emails, and website copy. Also for translation.

Image AIs: potentially useful for posters and social media, maybe for a podcast logo or a design for a cutting plotter. In my experience, many AI images look a bit “polished” in a way people now recognize—and some push back against that look. AI images can help for simple symbols or illustrations, especially if you can edit them afterward. They’re also useful for brainstorming photography concepts. But be thoughtful: a cheap‑looking AI image can turn readers off a good article.

Speech AIs: tools that turn speech into text and text into speech. Great for accessibility or large‑scale read‑aloud use. You might even drop snippets into a podcast. Use sparingly, though. If it’s clearly a website article being read aloud, fine. But if half your podcast is an AI voice, it leaves a strange taste. I wouldn’t do it.

Video AIs: you could generate short filler clips. Personally, I’m not a fan—especially because of energy costs. The more complex the task, the more resources it needs: water for cooling data centers and lots of electricity. With video models it’s enormous. A four‑second Google Veo clip, for instance, uses enough electricity to ride roughly 60 kilometers on an e‑bike. Two tiny clips, and you’ve effectively spent a full e‑bike battery. MIT Technology Review recently highlighted numbers like that. Text and image models use far less. So if you use a text model to plan an edit and then shoot the video yourself, you’re likely greener—and more creative—than fully generating it with a heavy video model.

Music AIs: extremely controversial. Musicians are pushing back as platforms get flooded with AI tracks. Fine for a fun experiment in confirmation class, maybe—but it won’t replace real playing and singing.

That’s the overview of what AI is, why you might use it, and how to approach it. In upcoming episodes, I’ll talk more about attitude and responsibility, how to combine AI with cutting plotters (I recently ran a workshop where we generated graphics and then cut them), and I’ll give a short primer on cutting plotters in general.

Thanks for listening. If you have questions, get in touch via elektropastor.de. I’m curious what you think about AI. Take care!